Il mondo dell’Intelligenza Artificiale negli ultimi anni è stati caratterizzato da sviluppi rapidissimi. Grandi player come OpenAI, Google e Meta hanno rilasciato modelli sempre più potenti, con aggiornamenti frequenti e sostanziali. Questa evoluzione ha generato un impatto dirompente, trasformando l’AI da curiosità tecnologica a risorsa cruciale per imprese, professionisti e consumatori.

Da metà 2024, però, la corsa alla pura performance tecnica ha iniziato a rallentare. Se prima ogni nuovo modello linguistico introduceva differenze marcate, oggi i miglioramenti fra una versione e l’altra sono più contenuti. Il “fattore wow” tende a diminuire, e questo determina uno spostamento dell’attenzione, non si cerca più tanto la prestazione record, quanto la capacità di integrare l’AI nei flussi di lavoro, nei processi industriali e nelle esperienze quotidiane.

Quest’anno, dunque, il settore dell’AI entrerà in una fase di consolidamento. Non assisteremo necessariamente a modelli linguisticamente rivoluzionari ogni mese, ma vedremo altre tipologie di sviluppi, come la diffusione dei canali, più contesti d’uso e interfacce, consolidando la maturità di questa tecnologia. L’obiettivo delle aziende del settore si è spostato per rendere l’AI Generativa un elemento naturale integrato nel tessuto digitale, dall’operatività aziendale, alla produttività personale, fino all’interazione con i sistemi fisici.

In questo articolo, tratto da un nostro webinar, esploriamo i trend in corso nel panorama dell’AI Generativa in questa fase di stabilzzazione e consolidamento.

AI trend 2025: multicanalità, la prima grande frontiera

La multicanalità è uno dei pilastri portanti di questa nuova fase. Se fino a poco tempo fa l’interazione con i modelli AI era quasi esclusivamente testuale, oggi il panorama si sta rapidamente ampliando. Il concetto stesso di canale va oltre il testo e si estende a voce, immagini, video, azioni dirette su schermo e molto altro. Siamo di fronte a una trasformazione che punta a integrare l’AI ovunque, rendendola uno strumento operativo, non più confinato a un singolo ambiente o a un unico linguaggio di input/output.

Realtime API, la base dell’interazione istantanea

Le Realtime API garantiscono interazioni fluide e senza latenza, elaborando input e fornendo output in millisecondi. Questo è fondamentale per canali vocali, dove in passato l’elaborazione prevedeva passaggi distinti, da audio a testo (speech-to-text), poi elaborazione, e infine da testo ad audio (text-to-speech). Grazie alle Realtime API e a modelli avanzati, si passa oggi a un approccio diretto voice-to-voice, che elimina la discontinuità tra input e output.

Questa innovazione supera i tradizionali IVR basati su flussi standard e tastierini numerici, offrendo conversazioni più naturali, immediate e personalizzate. Tuttavia, emergono sfide come il controllo dell’output in tempo reale e la limitata disponibilità di modelli voice-to-voice per lingue meno diffuse o dialetti locali. Sebbene applicazioni verticali e casi d’uso siano ancora in fase di test, il trend è chiaro, nel 2025 la voce diventerà un canale primario e integrato nell’esperienza utente.

Gemini 2.0, verso i Large Action Model

Un altro elemento chiave della multicanalità è la capacità dell’AI di interagire non solo tramite input testuale o vocale, ma anche con l’intero ecosistema digitale dell’utente. Questo introduce il concetto di LAM (Large Action Model), dove l’AI non si limita a interpretare contenuti, ma agisce direttamente su interfacce conversazionali, applicazioni e sistemi.

Gemini 2.0 rappresenta un passo in questa direzione. Si tratta di una suite multimodale che riceve input testuali, immagini, video in tempo reale e persino la condivisione dello schermo. L’AI diventa un collaboratore attivo nei processi operativi, come ad esempio per la compilazione di fogli di calcolo, per la navigazione tra file o per l’utilizzo di applicazioni web.

Anthropic Computer Use, l’AI alla guida del computer

Se Gemini 2.0 getta le basi, Anthropic Computer Use spinge il concetto un gradino più avanti. Non si tratta semplicemente di condividere lo schermo con l’AI, ma di concedere a quest’ultima un vero e proprio “controllo” dell’interfaccia. L’utente può chiedere all’AI di eseguire task complessi, come organizzare dati da una finestra a un’altra, completare documenti a molto altro ancora. In questo scenario, l’AI diventa un co-pilota operativo, in grado di illustrare all’utente ogni azione intrapresa, riducendo il gap tra conoscenza e operatività. Questa tecnologia spiana la strada alla digitalizzazione aziendale e a use case industriali avanzati, dove i modelli AI possono automatizzare mansioni ripetitive, migliorare l’efficienza dei flussi di lavoro e la produttività.

Project Mariner, l’integrazione nativa nell’esperienza utente

Google, con Project Mariner, offre una soluzione analoga a quella di Anthropic, ma integrata direttamente nel browser Chrome. L’obiettivo è rendere l’AI un elemento nativo dell’esperienza di navigazione. Non si parla più di strumenti esterni, ma di funzioni integrate in uno dei canali digitali più utilizzati al mondo. L’AI potrà analizzare, riorganizzare, produrre contenuti, interagire con pagine web e applicazioni cloud, tutto all’interno di un unico ambiente nativo.

Runner H, l’efficienza come parametro chiave

Runner H porta l’attenzione su un aspetto differente, l’efficienza dello strumento. Non basta che l’AI sappia compiere azioni, ma che le completi nel minor numero di passaggi possibile. In un contesto in cui l’AI diventa un attore operativo, la capacità di ottimizzare il workflow, ridurre i click e le operazioni necessarie, fa la differenza. Questa attenzione alla produttività e all’economia dei passaggi operativi riflette una maturità del mercato, in cui la competizione non è solo “farlo meglio”, ma anche “farlo prima e in modo più snello”.

NotebookLM, verso la creazione di contenuti complessi

Infine, la multicanalità si estende anche alla capacità creativa e interpretativa dell’AI. NotebookLM di Google consente di inserire un documento, un articolo o un testo come input, e di chiedere al modello di lavorarci su in maniera creativa. Non si tratta solo di estrarre informazioni o riassumere contenuti, ma di produrre output complessi. Per esempio, creare un episodio podcast in cui l’AI genera una conversazione plausibile tra due interlocutori che discutono il contenuto del documento originale. Questo sforzo creativo amplia radicalmente gli orizzonti dell’applicazione dell’AI, consentendo di esplorare nuove forme di engagement e narrazione.

Multimodalità, verso l’integrazione di diverse tipologie di dati

Mentre la multicanalità si concentra sul “dove” e “come” l’AI interagisce con l’utente, la tendenza AI alla multimodalità riguarda le tipologie di dati che l’AI può elaborare e generare, quali testo, immagini, audio, video o azioni su interfacce. La sfida consiste nel permettere ai modelli di interpretare e produrre contenuti provenienti da fonti eterogenee in modo coerente ed efficace.

Tradizionalmente, i modelli AI si sono focalizzati sul testo. Un esempio emblematico è ChatGPT, che riceve stringhe testuali in input e fornisce risposte dello stesso tipo. Negli ultimi anni, tuttavia, la ricerca ha esteso i confini di queste capacità, introducendo modelli in grado di generare immagini, sintetizzare voci realistiche, creare musica e persino controllare robot. L’obiettivo condiviso è integrare diversi formati in un’unica esperienza, consentendo passaggi fluidi tra testo, immagini, audio e video.

La frontiera più complessa è rappresentata dal video, che non è solo una sequenza di immagini, frame, ma un racconto che si sviluppa nel tempo. Per comprendere e generare video in modo efficace, un modello deve coglierne la continuità narrativa, la coerenza logica e la plausibilità fisica delle scene.

Sora, l’approccio di OpenAI al video generativo

OpenAI ha introdotto Sora, un modello progettato per ridefinire la creazione di contenuti video. Sora è in grado di trasformare input testuali o immagini statiche in brevi video animati, mettendo a disposizione strumenti avanzati di personalizzazione tra i quali Remix, che consente di modificare, sostituire o reimmaginare elementi di un video, una timeline personalizzabile, opzioni Loop e Preset.

Veo 2, la proposta di Google per la generazione video coerente

Google ha risposto alla sfida con Veo 2, un modello multimodale concepito per produrre video di elevata qualità, fino alla risoluzione 4K, caratterizzati da un realismo impressionante. Veo 2 eccelle nella simulazione della fisica del mondo reale e offre un controllo avanzato della telecamera, consentendo di selezionare stili di ripresa, angolazioni e movimenti complessi.

Kling, dare vita ai contenuti statici

Dal mercato cinese arriva "Kling", un modello che porta il movimento nelle immagini statiche. Kling trasforma semplici fotografie in brevi video animati, aggiungendo dinamismo e realismo ai contenuti. Ad esempio, una foto di un’auto può essere trasformata in un video dove l’auto si muove con una fisicità corretta, le ruote girano e i riflessi sulla carrozzeria cambiano in base alla luce e all’angolo di visuale.

Multisensorialità, dall’intelligenza virtuale all’interazione con il mondo fisico

Dopo l’integrazione dell’AI su più canali, ovvero la multicanalità, e la capacità di operare su diverse tipologie di dati, ovvero la multimodalità, il passo successivo tra i trend AI più forti del 2025 è la multisensorialità. Ciò significa permettere all’AI di interagire non solo con input testuali, visivi o sonori, ma anche con il mondo fisico.

Il linguaggio naturale è stato il primo senso sviluppato dai modelli AI, in quanto base dell’intelligenza umana. Poi, l’AI ha imparato a “vedere”, gestendo immagini e video, e “sentire” elaborando audio. Ora la sfida è implementare tattilità e movimento, consentendo ai modelli di interagire con l’ambiente fisico. Questo approccio, chiamato “embodiment”, punta a dare all’AI un corpo, reale o simulato, capace di percepire e agire con l’ambiente circostante.

Per raggiungere questo traguardo, la ricerca si sviluppa in due filoni paralleli:

- La robotica fisica consiste nella creazione di robot sempre più agili, precisi e intelligenti, in grado di interagire con l’ambiente in modo fluido, afferrare, spostare, assemblare, manipolare oggetti e compiere azioni complesse.

- La world simulation invece consiste in una simulazione avanzata di mondi virtuali, in cui l’AI può essere addestrata, testata e perfezionata a costi e rischi inferiori rispetto al mondo reale. I videogiochi, ad esempio, forniscono ambienti controllati nei quali l’AI impara a gestire dinamiche fisiche, interazioni tra agenti, scenari complessi e imprevisti. Una volta addestrati in questi contesti simulati, i modelli possono poi essere traslati nella realtà con maggiore sicurezza ed efficacia.

Genie 2, creare agenti intelligenti in ambienti simulati

Genie 2 è una piattaforma che si concentra sulla creazione di agenti virtuali in ambienti 3D complessi. Immaginiamo un contesto simile a quello di un videogioco sandbox, in cui l’AI deve imparare a interagire con oggetti, personaggi e scenari dinamici. Ad esempio, un agente potrebbe imparare a raccogliere risorse, costruire strumenti, risolvere puzzle e collaborare con altri agenti, il tutto in un mondo simulato.

Diamond, intelligenza tattile e problem solving

Diamond è un progetto che si focalizza sull’AI capace di percepire e reagire a stimoli tattili simulati. In un ambiente virtuale, Diamond può imparare a distinguere la consistenza, la solidità e la forma degli oggetti, e a manipolarli di conseguenza. Immaginiamo un caso d’uso, l’AI “tocca” virtualmente un oggetto e deve capirne la forma per poi afferrarlo correttamente.

Worldlabs, addestramento integrato in mondi virtuali complessi

Worldlabs è una piattaforma che porta il concetto di simulazione a un livello superiore, consentendo la creazione di veri e propri mondi digitali multisensoriali. Qui l’AI non impara solo a vedere o a toccare, ma a interagire con un ecosistema digitale completo composto da animali, piante, materiali con proprietà fisiche differenti, cicli giorno-notte, condizioni atmosferiche variabili.

Omniverse di NVIDIA, la piattaforma per la simulazione industriale

NVIDIA ha sviluppato Omniverse, una piattaforma di simulazione e collaborazione virtuale estremamente avanzata, pensata per creare universi digitali in cui addestrare e testare robot, veicoli autonomi e dispositivi IoT. Il vantaggio principale è la possibilità di “allenare” i robot in modo intensivo, senza alcun rischio o costo legato a danni a macchinari, fermo produzione o incidenti.

1X, robotica reale al servizio dell’industria

Alcune aziende hanno già cominciato ad adottare robot addestrati con questi principi. 1X, ad esempio, è una realtà che sta integrando robot autonomi in processi industriali, automatizzando task ripetitivi e potenzialmente pericolosi per gli esseri umani.

Sostenibilità economica, dalla ricerca alla produzione

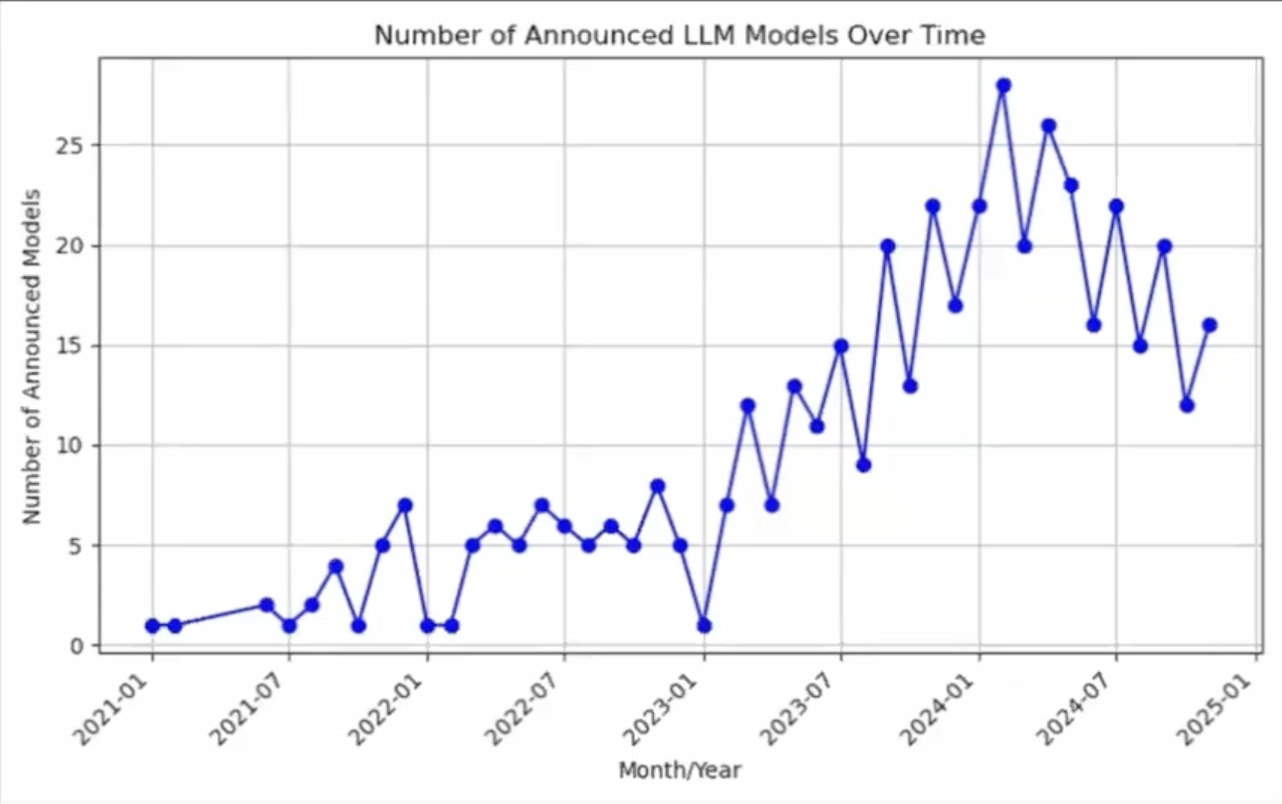

Come già discusso in precedenza, i modelli AI stanno raggiungendo un plateau prestazionale. Se in passato ogni nuova generazione di modelli portava differenze nette in termini di capacità e qualità, oggi i miglioramenti sono più incrementali e meno eclatanti.

A testimonianza di questo cambiamento, possiamo notare che l’andamento del numero di nuovi LLM annunciati dal 2021 al 2025 ha avuto un un picco tra la fine del 2023 e l’inizio del 2024, seguito da un progressivo calo. Questo riflette uno scenario di consolidamento, in cui non è più cruciale presentare ogni mese un nuovo modello, bensì rendere economicamente e operativamente sostenibili quelli già presenti sul mercato.

Questo contesto spinge le aziende a ripensare la propria strategia, puntando meno sulla pura ricerca e più sulla creazione di prodotti stabili, utili e sostenibili dal punto di vista economico.

Dalla sperimentazione alla prodottizzazione

Il focus, dunque, si sposta dal semplice “fare meglio” al “fare in modo sostenibile e scalabile”. Ciò significa integrare l’AI in prodotti e servizi concreti, utili per le persone nelle loro attività quotidiane.

Questo trend mira a rendere l’AI una componente standard e naturale nei diversi contesti d’uso, dagli Agenti AI per la customer experience, agli strumenti di produttività personale, fino alle piattaforme di analisi dati industriali. La parola chiave diventa “prodottizzazione”: trasformare prototipi e dimostrazioni in prodotti finiti, configurabili, stabili e con un modello di business sostenibile.

Monetizzazione e modelli di business

Un esempio lampante è l’approccio di OpenAI. Dopo aver conquistato il mercato con ChatGPT, l’azienda ha deciso di sperimentare nuovi modelli di monetizzazione, quali l’introduzione di annunci pubblicitari integrati nei propri servizi.

Allo stesso modo, sempre OpenAI, ma anche altri player, stanno guardando a settori storicamente remunerativi, come il “Military Tech”, per creare partnership e applicazioni specifiche. Questa evoluzione, seppure in contraddizione con la mission stessa dell’azienda, riflette la necessità di confrontarsi con un mercato reale, in cui prodotti e soluzioni devono generare valore concreto per gli investitori e per le organizzazioni che li adottano.

Il mercato come arbitro finale

Oggi, la sfida non è solo produrre tecnologia avanzata, ma creare soluzioni che possano essere vendute, mantenute, integrate nei processi esistenti e supportate nel lungo periodo. La realtà del mercato impone di trovare fonti di ricavi tangibili, sia per sostenere i costi computazionali elevati dei modelli su larga scala, sia per continuare a finanziare ricerca e sviluppo.

Il passaggio dalla ricerca alla produzione è dunque una naturale conseguenza della maturità tecnologica. Le aziende devono trovare un equilibrio tra innovazione, etica e monetizzazione. Il risultato? Un panorama in cui i modelli AI sono meno appariscenti sul piano dei continui balzi evolutivi, ma più solidi, accessibili e integrati nelle applicazioni del quotidiano. In definitiva, la sostenibilità economica diventa la condizione necessaria per garantire la continuità dell’innovazione e la diffusione capillare dell’AI nel tessuto produttivo e sociale.

Per concludere, l’evoluzione dell’AI nei prossimi anni sarà caratterizzata da un assestamento delle performance e da un passaggio cruciale dalla pura ricerca allo sviluppo di prodotti realmente integrati e sostenibili. La multicanalità, la multimodalità, la multisensorialità e la sostenibilità economica guideranno l’innovazione, tracciando un percorso dove l’AI non sarà più soltanto una frontiera tecnologica di nicchia, ma un attore fondamentale nella quotidianità, nella produttività e nel mercato globale.

FAQ

1. Quali saranno gli ambiti applicativi dell’AI nel 2025?

Nel 2025 l’AI si radicherà in settori molto diversi tra loro, diventando un supporto tangibile per la produttività, la customer experience, il servizio clienti, la creatività e l’ottimizzazione dei processi. Nei contact center, ad esempio, gli Agenti AI non si limiteranno a fornire risposte, ma anticiperanno le esigenze degli utenti. In ambito industriale guideranno robot e macchinari per ridurre gli sprechi, mentre nel campo dei contenuti digitali aiuteranno a generare testi, immagini e video di qualità. Questa integrazione sarà resa possibile dall’inserimento naturale dell’AI in browser, applicazioni cloud e piattaforme che già utilizziamo quotidianamente.

2. Perché la velocità degli sviluppi tecnologici dell’AI sta rallentando?

Non si tratta di un vero e proprio rallentamento, bensì di una fase di consolidamento. Dopo anni di progressi rapidi, i nuovi modelli non offrono più salti rivoluzionari a ogni nuova release. L’attenzione si è spostata sull’integrazione affidabile e scalabile delle soluzioni esistenti, sulla capacità di gestire dati e formati eterogenei e sull’allineare l’AI ai flussi di lavoro reali. Questo approccio favorisce prodotti solidi e sostenibili, capaci di generare valore nel lungo periodo.

3. In che modo l’AI diventerà parte integrante delle attività quotidiane?

L’AI del 2025 sarà sempre più intrecciata alle piattaforme e ai servizi che già utilizziamo, senza risultare intrusiva o nascosta. Non dovremo andare a “cercarla”, sarà presente nei nostri browser, nei software di analisi dati, negli strumenti di automazione e nei dispositivi domestici. Parleremo con l’AI in linguaggio naturale, le affideremo compiti complessi e ne sfrutteremo le potenzialità creative e organizzative. In questo modo, diventerà un partner tangibile e affidabile, inserito in modo fluido nelle nostre attività e abitudini digitali e non.